深入浅出谈AI光模块需求

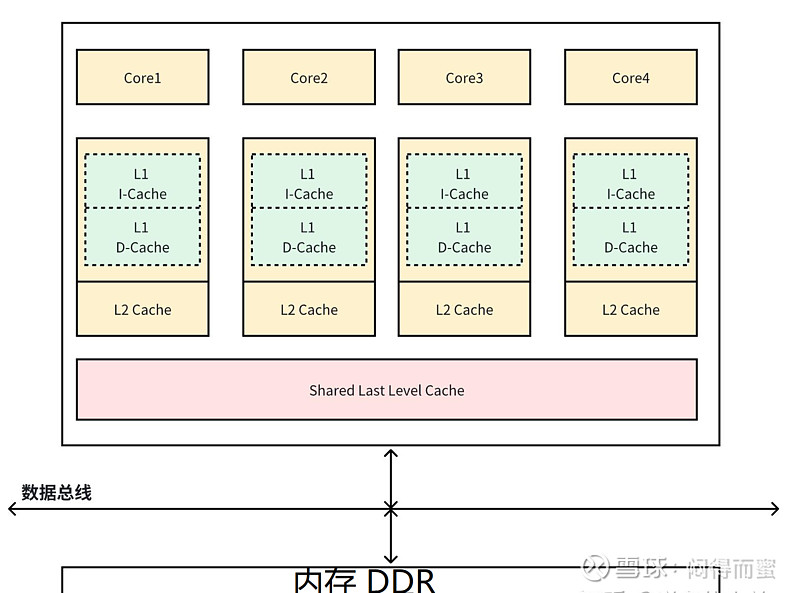

性能提升的秘密武器:缓存

CPU访问一次DDR内存空间,需要几百个时钟周期,如果没有其他办法,将会导致99%的时间CPU时间在等待数据而空转。所以科学家就想出了一种办法: Cache。

计算机的程序和数据访问范围虽然很大,但是具有明显的局部性特征:在某一时刻,程序所需要的下一条、或者几条指令很大的概率就在附近,某一时刻前后所需要的数据也大概率就在附近。在读取当前指令和数据的时候,顺便把前后一定范围的指令和数据都读取到靠近CPU的Cache里面,这样当CPU执行完指令,去提取下一条指令的时候,发现这些数据“就在自己房间里面”,从而大大提高了CPU的实际运行性能。

这就是CPU通过Cache机制获得巨大性能增益的原理。Cache有可以分成好多层:

随着芯片工艺进步,三级cache(LLC, Last Level Cache)也越来越多的集成在处理器内部了。

AI计算性能提升的窍门

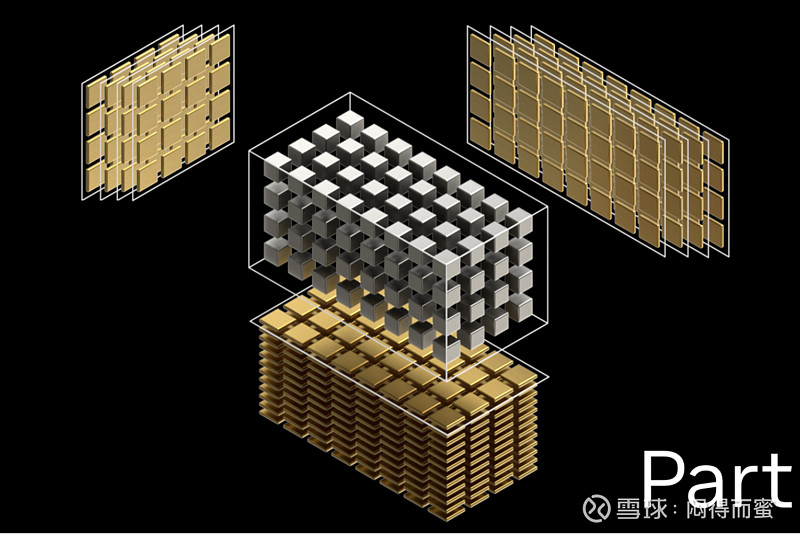

AI算法在数学层面,最终是大规模的矩阵、张量运算。

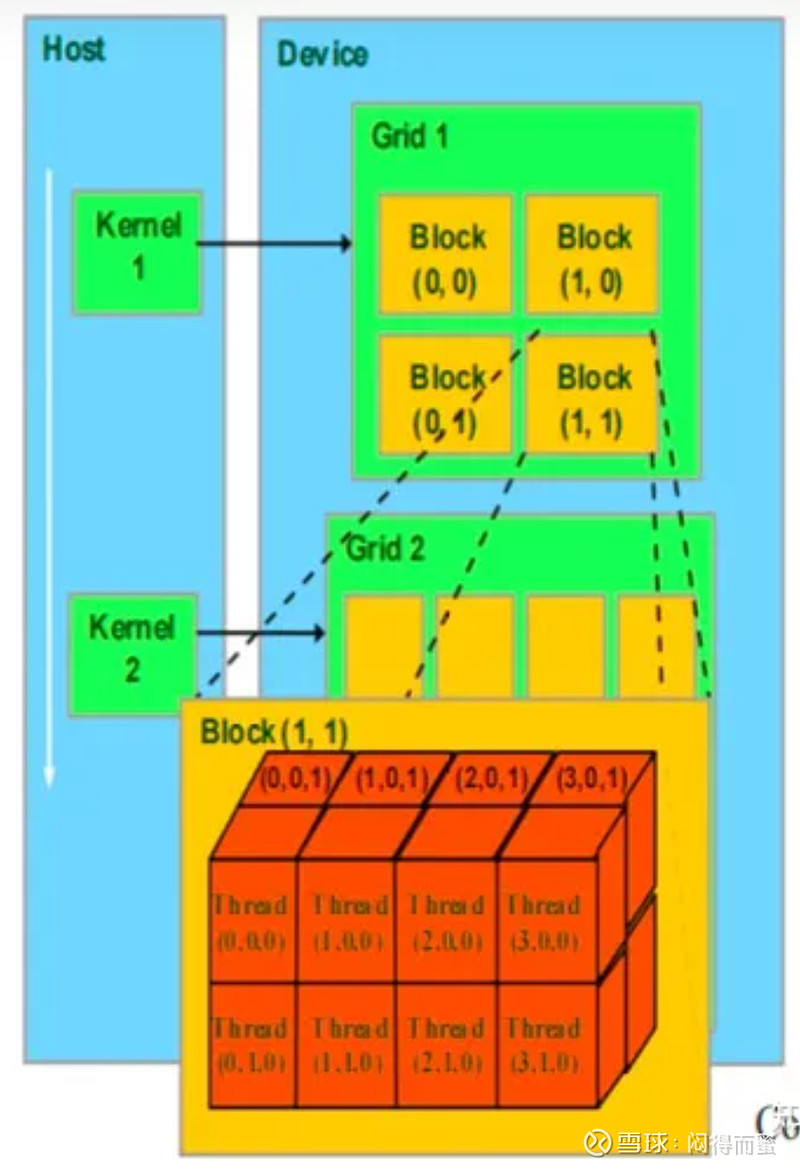

随着算法越来越复杂,这些矩阵动十分庞大,一张GPU卡无法在同一时刻算完,怎么办呢?只能很多张GPU卡在一起,每人分一部分,算完后再一起汇总出结果。

这种方式,计算机科学的专业术语是大规模并行计算,所组成的硬件叫超级计算机集群。但是呢,网络通信是有延时、抖动、掉包等问题的,这么多GPU连在一起,GPU与GPU如果不能够及时的通信,就会面临类似 CPU遇到的“内存墙”问题,大幅降低性能。

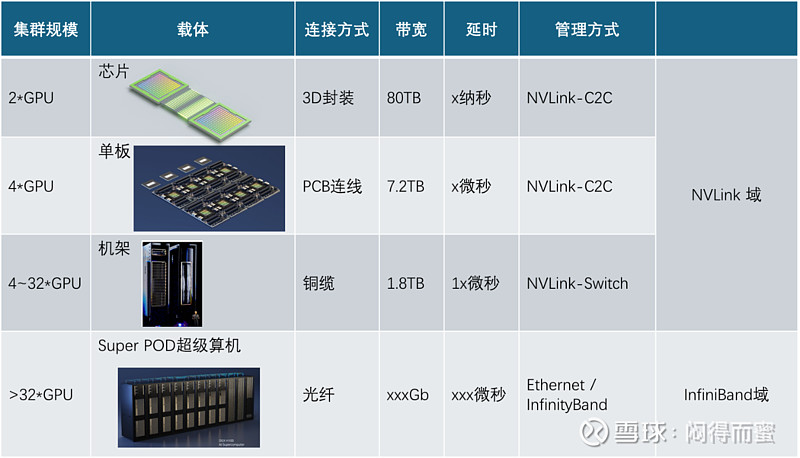

怎么解决呢?思路与Cache机制有异曲同工之妙。Cache的依据是指令和数据的局部性,AI矩阵运算也同样有局部性的特征,某个子矩阵往往跟周围几个子矩阵关系最密切,而离较远的子矩阵不关联。所以,如果我们把两个GPU用最高的通信接口整合在一起,就能解决大部分问题,从而显著提高算力。依次类推,能不能把4个GPU堆叠在一起? 能不能把32个GPU堆叠在一起?像内存的Cache一样,形成层次化的架构? 答案是:完全可以。

所以,AI超算集群,是一种层次化的集群架构。

英伟达AI集群解析

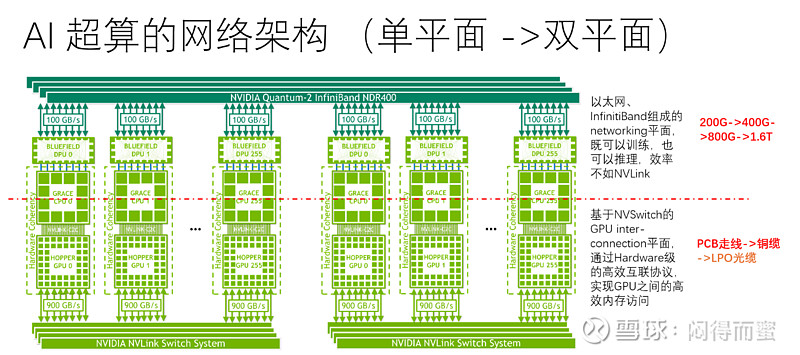

上文的图中已经展示了Nvidia的AI集群系统,分成两大种内:NVLink和InfiniBand。其中NVLink术语Nvidia专有的技术,有硬件直接完成GPU之间内存的互相访问,无需CPU的干预。而InfiniBand则要由CPU进行管理,通过虚拟化的形式,让GPU之间互相访问。这两种方案的性能差别很大,所以,Nvidia每一代新架构发布,都想方设法扩大NVLink 的势力范围。 NVLink和InfiniBand的关系可以这么类比着理解:

所以这里有一个很重要的概念:

1、即使每一个CPU芯片内部有大量的L1、L2、L3缓冲,每台服务器还是需要配置大量的内存条,Cache的作用只用于提升性能。内存条的多少,由程序的大小和数据规模的规模决定。

2、同理,AI服务器集群中,即使大量使用NVLink做加速,但还是需要大规模的InfiniBand将更多的GPU互联起来,完成更大的AI运算。InfiniBand的规模:由算法模型的复杂度和训练的并发度(时间)来决定;由芯片硬件所能支撑的集群规模上限约束;

所以,在一个集群中,NVLink、InfiniBand(光模块)的数量可多可少,根据需求和投资规模来决定。总结一下,英伟达的AI算力集群是一个双平面的架构:

NVLink主要负责近距离并行计算,提高性能;InfiniBand主要负责扩大集群规模。

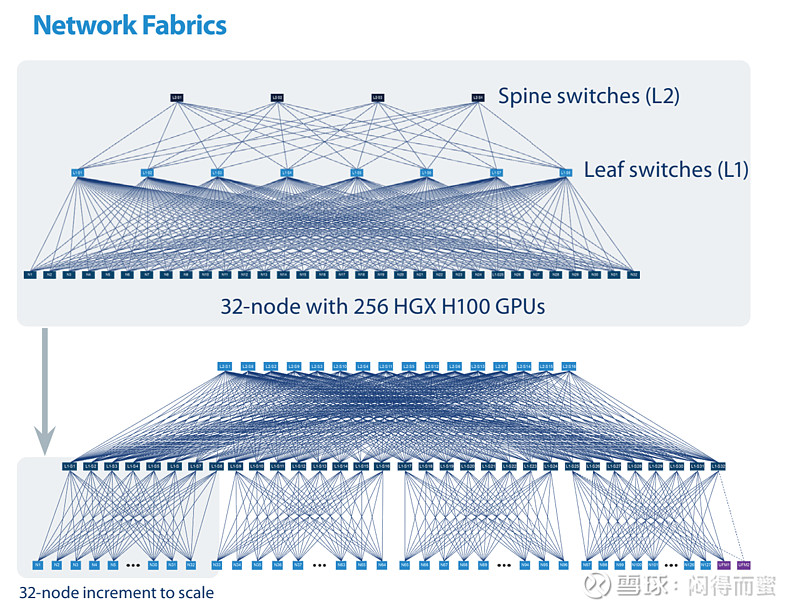

Spine-Leaf:InfiniBand的网络架构

为了使集群系统内部的GPU之间能均等地访问,InfiniBand均采用Spine-Leaf网络架构。这种架构下,任何两台设备之间的访问距离均相等,降低延迟。

Hopper架构下的集群系统

所需要的光模块配置关系

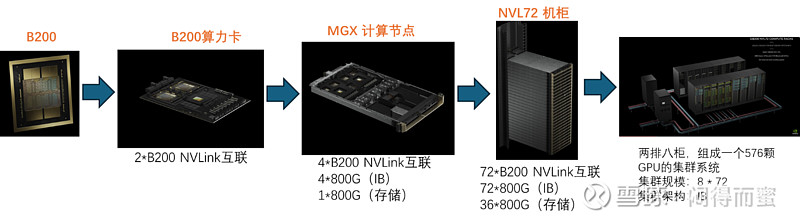

Blackwell架构的集群系统

所需光模块的配置关系

上表格可以看出,B200 NVL72配置模型下,当集群的GPU数量超过576时,平均一个GPU需要配置7.5支800G的光模块,4支1.6T的光模块。单从GPU与光模块的配比看,新架构的光模块需求显著增加了3倍。

为基于相同的算力水平公平对比,新旧两种架构的GPU算力都归一化到H100,按照官网的数据B200=3*H100。那么Blackwell架构下的 DGX B200 NVL72 SuperPod配置下,只要集群GPU数量超过2K(等价为H100的6K),光模块的数量明显比上一代要多,大概多出50%。

当人,可以购买B200新架构的目的是希望有更强大的性能,以支撑越来越庞大的算法模型。所以,新的架构必将驱动高速光模块快速增长。

总结

一、为了提高GPU的性能,增加NVLink投资;

二、为了提高GPU的集群规模,增加InfiniBand规模;

三、Nvidia的架构主要围绕GPU芯片和NVLink的集成度创新,InfiniBand与架构弱相关;

四、当IB域 > NVLink时,因为GPU与GPU之间是全连接网络,InfiniBand的规模可大可小,决定因素有:

1、只由GPU的数量决定,与NVLink的规模无关;

2、有应用场景和AI算法决定,如果AI算法生成的运算有更强的内聚性,GPU之间的负载较轻,则可以减少IB网络的投资。

3、因为当前阶段的AI还处于初级阶段,算法只会越来越复杂,所以,并不具备减少IB网络投资的前提;

4、有投资预算决定。