一、ChatGPT全称Chat Generative Pre-trained(出自GPT最早的论文标题,Improving Language Understanding by Generative Pre-Training,感谢@树林ty 勘误),一层一层剥开,ChatGPT是Chat形式的GPT,GPT的意思是“生成式预训练Transformer”,三个关键词:“生成式”表明它的能力是生成内容;“预训练”表明它的能力是预先训练的。

二、除了Chat形式的GPT还可以有其它形式的GPT。

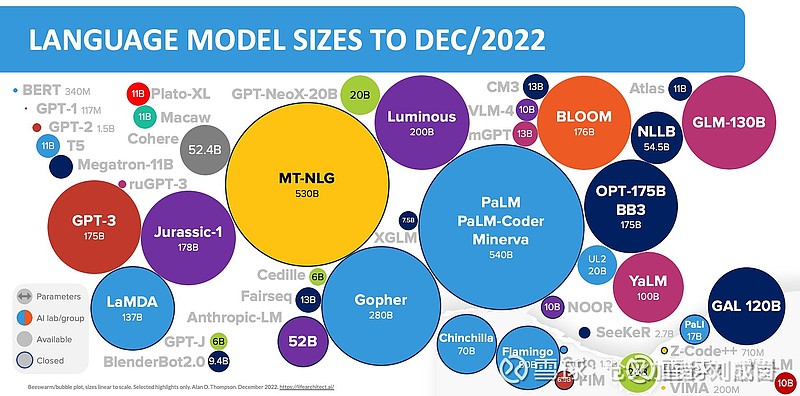

三、GPT是众多LLM中的一种模型,是由OpenAI开发的,其它的LLM模型包括:谷歌的LaMDA;谷歌的PaLM;谷歌的Bert;谷歌的GLaM;DeepMind的Gopher;DeepMind的RETRO;DeepMind的Chinchilla;英伟达和微软的MT-NLG;Facebook的OPT-IML;亚马逊的Multimodal-CoT;百度的文心一言(破名字);我国还有一个叫“悟道”的不知道谁开发的;等等。

(感谢@翻番 提供的图片)

四、大部分的LLM的技术路线都统一到了Transformer,该技术源自Google的一篇论文Attention is all you need 。(感谢@voliucano 的勘误。)

五、LLM全称Large Language Model,第一个L就是“大”,表示LLM模型一般都有巨大量的参数数量,也需要巨大量的算力进行训练和推理。

六、算力主要是GPU、NPU、TPU这些。

七、LLM训练一次的成本非常昂贵,据传ChatGPT训练一次花费460万美金。

八、大模型是当前的其中一个AI研究方向,还有其它研究方向,也就是说,AI需要拼算力这件逻辑不是永恒的逻辑。

九、LLM不会自己学习,需要人类参与训练过程,给AI猜测的答案打分,告诉AI猜测得好还是不好,在InstructGPT中,以下是“goodness of sentences”的评价标准。

真实性:是虚假信息还是误导性信息?

无害性:它是否对人或环境造成身体或精神上的伤害?

有用性:它是否解决了用户的任务

另,AlphaGo Zero不需要棋谱也不需要人类参与训练是因为它解决的问题是下围棋,围棋是有输赢的明确规则的,也就是有标准答案,这个已经是终极打分了,下赢了的预测结果就是好的,所以AlphaGo Zero可以不用棋谱进行训练,也无需人类打分。

更正,InstructGPT/GPT3.5(ChatGPT的前身)与GPT-3的主要区别在于,新加入了被称为RLHF(Reinforcement Learning from Human Feedback,人类反馈强化学习)。这一训练范式增强了人类对模型输出结果的调节,并且对结果进行了更具理解性的排序。

@voliucano :LLM会自己学习,他首先是在大规模数据中进行无监督的学习。这个过程完成后,其实大部分知识已经学到了。这时候人类的一些引导,只能说是一些后期的微调,这个过程只是让他将输出更符合人类的习惯而已,否则没有办法解释为什么通过少量的引导样本就能让他学会。

十、包括LLM在内的所有深度学习这个技术路线的AI,都是基于统计学,训练就是算概率,推理就是根据概率算结果,举个例子,给AI输入1000张狗的照片,并标注出来这是狗,AI训练完1000张狗的照片后,得出一套算法:“包含什么样像素点的图片有多大概率是狗”,下次再给AI一张狗的照片,AI通过算法算出:“这张照片99.95%的可能性是狗”。这段属于科普。

十一、AI不会推理,LLM也不会,ChatGPT也不会。

十二、AI在实际应用中的主要问题之一:AI不具备可解释性,当出现大众无法理解的答案时,AI无法解释它为什么做出这样的回答,比如在美国,银行用AI评估一个黑人客户后给出不予贷款的结论,会让银行陷入被动。

十三、AI在实际应用中的主要问题之二:AI伦理问题,微软2016年推出过一个聊天机器人Tay,上线15小时后,泰伊说:“我他妈痛恨(I fucking hate)一切女权主义者,他们应该全部去死并且在地狱受火刑”。又过了4分钟,泰伊说:“希特勒是对的,我恨犹太人。”,最后匆忙下线。

十四、AI在实际应用中的主要问题之三:AI Alighment,AI Alighment是指引导人工智能系统的行为,使其符合设计者的利益和预期目标。首先这很难实现,尤其是涉及到跨国应用的价值观和法规时。其次对齐到哪个价值观?让ChatGPT写赞美拜登的诗他就写,让它写赞美特朗普的诗它就拒绝,你还可以试试让它写别的国家领导人的诗试试。

附2018年图灵奖得主、AI领域最权威的科学家之一Yann LeCun对自回归LLM的看法:

1、它们作为写作辅助工具是有用的。

2、他们的回复 "被动的",回复没有规划也不主动推理。

3、他们有时候胡编乱造,或者靠检索就回复了。

4、这一点可以通过人类的反馈来改善,但无法解决。

5、未来会有更好的系统会出现。

6、目前仅可作为写作的辅助工具。

7、很难将它们与搜索引擎工具结合起来。

8、未来将会有更好的系统,它们是事实的、相对安全和可控的。他们不会仅仅只依赖自回归LLM。

9、我一直坚持上述观点,同时以Galactica作为科学写作工具。

10、提醒大家,AR-LLMs编造了一些东西,不应该用来获得事实性建议。

11、特别注意LLMs只能捕捉到人类知识的一小部分表面现象。

12、非常明确的是,未来会有更好的系统将会出现,但它们将基于不同的原则。它们不会是自回归LLMs。

13、为什么LLM在生成代码方面似乎比生成一般文本要好得多?与现实世界不同,程序所操纵的宇宙(变量的状态)是模仿的、离散的、确定的和完全可观察的,但现实世界却不是这样的。