Jim Fan预测全押中了

虽然OpenAI的这波更新在我们看来非常炸裂,但其实英雄所见略同,Jim Fan大佬表示「我早就说过应该这么干」。

在昨天发布会召开之前,他就发布了一篇推文,深入浅出地讲解了实时语音助手的技术路径,基本可以当作OpenAI技术报告的大纲了。

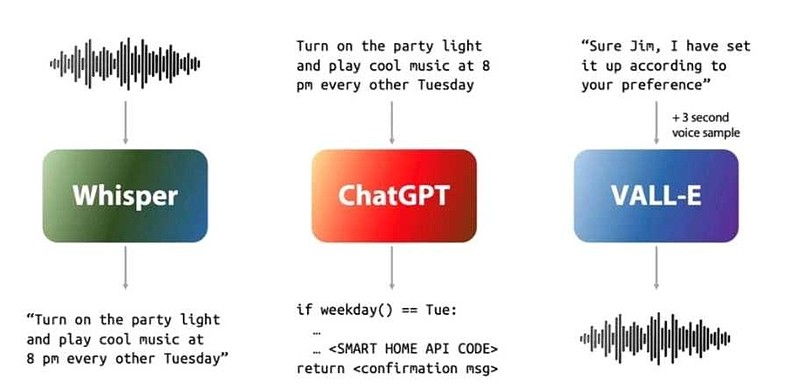

推文中首先表示,几乎所有的语音AI都需要经过3个阶段的推理——语音识别、LLM和语音合成。

然而,如果只是非常简单地把三种模型集成在一起,每次回答问题就会有接近5秒的延迟时间,这会造成用户体验断崖级的下降,无法打造「沉浸式对话」。

要想解决延迟问题、打造实时语音AI,就不能仅仅考虑三个子模型的加速,还需要重新考虑整个pipeline,让各个阶段尽可能重叠在一起,就像人类对话时都是一边听一边构思怎么说。

用一句话总结就是,「端到端模型总能胜出。」

不仅如此,发布会上展示的ChatGPT新特性,也都被Jim Fan一一点到,比如适时插入语气词、处理对话中的「打断」等等,简直是一波「神预言」。